Sieć w serwerowni podlega zupełnie innym ograniczeniom niż sieć operatorska. Przez długi czas rozwój obu był bardzo powiązany, ale aktualnie urządzenia w DC i przeznaczone do pracy na duże dystanse to dwa różne światy. Rozwój sieci w centrach danych napędzany jest z jednej strony przez coraz większe potrzeby ruchu storage, a z drugiej – ograniczany możliwą do uzyskania gęstością i kosztami rozwiązań.

- Aktualny stack prędkości używany w serwerowni wygląda następująco:

- 1 Gbit/s – miedź

- 10 Gbit/s SFP+ – w większości na krótkich kablach DAC – bardzo powolna adaptacja rozwiązań opartych na miedzi. Rynek oczekuje na przesilenie kosztowe i spadek cen switchy TOR opartych na miedzi.

- 25 Gbit/s SFP28 – optyka lub DAC – używany w obrębie kampusu

- 40 GBIt/s – QSFP – optyka lub DAC – czasami używany na kablach splitujących 40 GBit/s à 4x 10 Gbit/s – standard wymierający, zastępowany przez 25 Gbit/s lub 100 Gbit/s

- 50 Gbit/s – tylko na kablach DAC jako połowa porty 100 Gbit/s oraz jako SFP-DD

- 100 Gbit/s – QSFP28 – optyka i DAC jako podstawa szkieletu sieci wewnętrznej i storage

- 200-400 GBit/s – QSFP-DD optyka i DAC

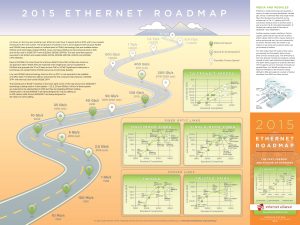

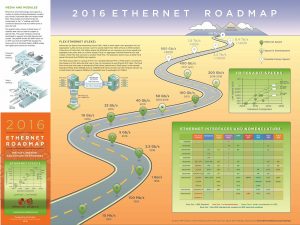

Relatywnie niedawno pożegnaliśmy się z ustaloną dawno temu mapą – 1 Gbit/s, 10 Gbit/s, 100 Gbit/s, 1 Tb/s. Wyglądającą pięknie, ale to zbyt ambitna, a przede wszystkim wynikająca bardziej z marketingu próba wprowadzenia kolejnych prędkości poprzez dodanie zera do kolejnej generacji, w zupełnym oderwaniu od technologii żyjącej w rytmie kolejnych potęg cyfry dwa. Zmianę myślenia dobrze oddaje różnica pomiędzy roadmapami z 2015 i 2016 roku, zmiana 1 Tb/s na 1,6 Tb/s oraz 10 Tb/s na >10 Tb/s.

Największe znaczenie miało wprowadzenie standardu QSFP (Quad SFP), gdzie cztery porty 10 Gbit/s tworzyły jeden port 40 Gbit/s. Kolejne planowane generacje portów na pewno bazować będą na bazowej prędkości portu (25 Gbit/s, 50 Gbit/s, 100 Gbit/s, 200 Gbit/s) oraz jego multiplikacji (x2, x4, x8, być może też x16), co pozwoliło nam na ustalenie celu, jakim jest 1,6 Tb/s (8x 200 Gbit/s) na rok 2024 oraz dalszych kroków aż do 8 Tbit/s (8x 1 Tb/s).

Odprowadzanie ciepła

Obecnie największym ograniczeniem technologicznym w sieciach centrów danych pozostaje odprowadzanie ciepła. O ile urządzenia operatorskie mogą zajmować więcej miejsca, pozwalając na większą liczbę radiatorów, tak w centrum danych switch TOR nie powinien zajmować więcej niż 1U, a aktualne tendencje bardzo intensywnie promują rozwiązania ½ U.

Żeby zrozumieć problem ciepła, warto spojrzeć na liczby. Switch TOR 400/200 Gbit/s pozwala na gęstość 32 portów na 1 U z planowaną rozbudową do 64 portów. Takie rozwiązanie generuje jednak ponad 500 W ciepła w tym samym 1U, co jest ilością mocno niepożądaną. Tego typu rozwiązania są projektowanie dla Giga Centrów danych, a dopiero potem adoptowane przez inne firmy. Barierą rozwoju jest wzrost zużycia prądu przez urządzenia sieciowe i zwiększenie obciążenia ponad standardy, jakie były projektowane dla całego DC w momencie budowy, co pociąga za sobą znaczący wzrost kosztów.

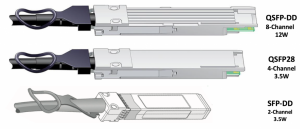

Aktualnie każde zwiększenie przepustowości pojedynczej transmisji wymaga zwiększenia mocy lasera, a to – co oczywiste – przekłada się na większy pobór mocy, większe ciepło, i więcej innych problemów. Już odprowadzenie ciepłą z końcówki QSFP-DD doprowadziło do stworzenia absurdalnie dużego radiatora. Następna generacja będzie potrzebować przełomów technologicznych lub będzie zajmować więcej miejsca. Kolejnym problemem jest brak trwałych, tanich materiałów pozwalających w sposób pewny przesyłać tak duże ilości danych.

Ewolucja prędkości

W tym kontekście mapa naszkicowana przez Ethernet Alliance wydaje się lekko nieaktualna. Kolejna generacja prędkości może zostać mocno opóźniona. Warto zauważyć, że przy obecnej generacji portów 200/400 Gbit/s kolejność pojawiania się elementów ekosystemu była postawiona na głowie. Najpierw dostaliśmy kable DAC o przepustowości 200/400 Gbit/s, później switche, następnie standard portu, a na samym końcu optykę i moduły optyczne. Wyraźnie widać, że technologia stojąca za tak dużymi przepustowościami jest co najmniej skomplikowana.

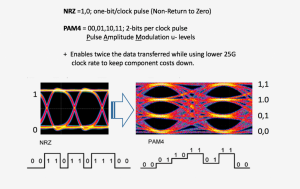

Jak już wspominałem, aktualnie wchodząca generacja switchy posiada porty 400 Gbit/s. QSFP-DD, natywnie 8x 50 Gbit/s z możliwością downgrade’u do 25 Gbit/s na kablach DAC. Oznacza to w praktyce możliwość zamontowania w 1U na 32 portach 400 GBit/s do 128 urządzeń o niższej przepustowości – czyli z 1U będziemy w stanie obsłużyć switchem TOR dwie pełne szafy w standardzie 47U.

Serwery generacyjnie pozostają daleko w tyle. Już teraz do obsłużenia dwuportowej karty 400 Gbit/s potrzeba PCI-E 5.0 x16. Obecnie w produkcyjnych płytach stosowane jest PCI-E 3.0, zapewniające jedynie 25% potrzebnej przepustowości. Z tego powodu coraz bardziej prawdopodobne jest przeskoczenie PCI-E 4.0, lub bardzo krótki czas życia tego standardu.

Standardy portów

Tak jak jesteśmy świadkami ewolucji prędkości, tak samo obserwujemy też zmiany portów. Chłodzenie, materiały, skręcanie sygnału z ośmiu linii – każda z tych rzeczy wymaga przeprojektowania standardu, a jego wygląd i ewolucja nie są czymś oczywistym. Sam fakt zmian w ilości planowanego ciepła z 5 do 13,5 W na ostatniej prostej zmienił bardzo dużo. Przez bardzo długi czas standardem był format SFP oraz jego szybsze rozwinięcie SFP+. Standardy były wstecznie kompatybilne.

Od kilku lat dostępne są krótkie kable miedziane zakończone końcówkami SFP+, które wpłynęły na popularyzację sieci 10 Gbit/s w serwerowniach. Skutkiem ubocznym ich stosowania było uśmiercenie standardu opartego na miedzi 10G BASE-T. Switch z krótkimi kablami kosztował niewiele więcej niż infrastruktura wyposażona w czysto miedziane przyłącza, ale był dużo łatwiejszy do spięcia z resztą obiektu.

Nowszy standard to SFP28, również kompatybilny wstecznie do SFP i SFP+ i obsługujący prędkość na pojedynczej linii 25 Gbit/s. W Polsce standard ten nie zdążył jeszcze zagościć w centrach danych, a już widać jego następców o przepustowości 50 Gbit/s.

Ponieważ 10 Gbit/s już od kilku lat nie jest wystarczającą prędkością dla hosta, nowsze centra danych takie jak Data Space implementują natywnie 25 Gbit/s jako rozwiązanie o większym planowanym czasie życia. Ta zmiana wymusza jednocześnie pominięcie QSFP i wprowadzenie od razu QSFP28 – lub QSFP-DD, jeżeli jesteśmy bardzo ambitni lub potrzebujemy dużej przepustowości.

Dynamika zmian i możliwych do uzyskania prędkości jest bardzo duża. W dobie rozproszonych środowisk mikro serwisów, komunikacja pomiędzy fizycznymi maszynami staje się coraz istotniejsza i zaczyna być kolejnym – obok storage i ogólnie pojętego contentu multimedialnego – kołem zamachowym wzrostu szybkości zmian w sieciach DC.